ビジネスを変えるAIの新たな展開!OpenAI DevDay 2024で発表された最新AI技術とは

AI技術の進化が加速する今、どの業界でもその導入は避けられない話題です。

2024年10月2日 日本時間AM2:00に行われたOpenAI DevDayでは、AIの最新技術と、そのビジネス活用の可能性が明らかにされました。

ここで発表された内容は、ただの技術革新にとどまらず、今後のビジネスの進め方を大きく変える可能性があります。

たとえば、営業やマーケティングの効率化から、データ分析の高速化まで、AIはこれまで不可能だったレベルの精度とスピードを実現しています。あなたのビジネスでも、「もっと効率的に」「もっとインパクトのある成果を」と考えているなら、今回の発表はまさに聞き逃せない内容です。

このブログでは、OpenAI DevDay 2024で発表された革新的な技術と、それがビジネスにどのような影響を与えるのか、わかりやすく解説していきます!

AIを使って一歩先行くビジネス展開を目指すなら、ぜひ最後までご覧ください。

▶️公式サイト:

https://openai.com/devday/

徹底解説をまずは動画でご覧ください!

概要のまとめ

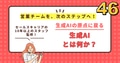

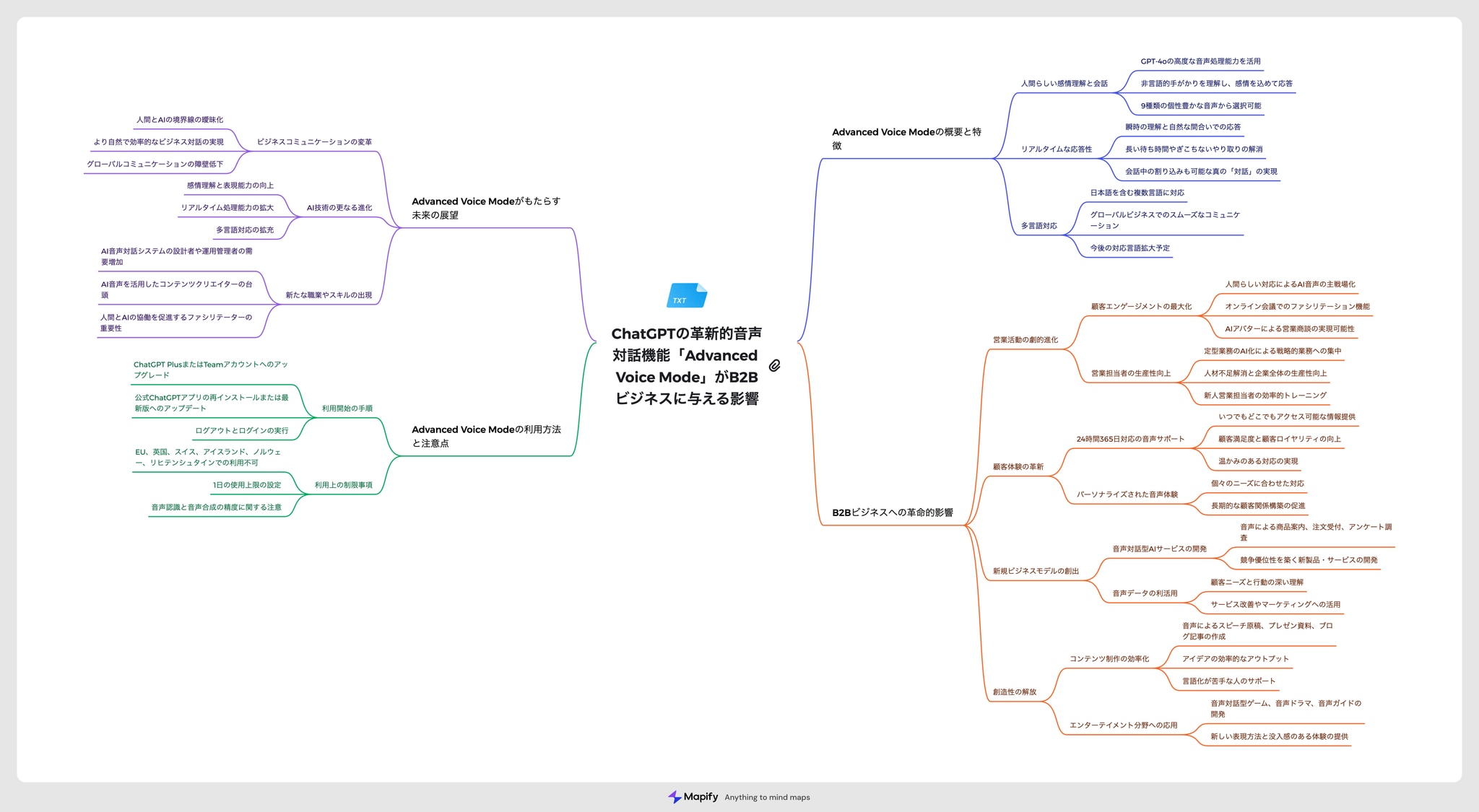

リアルタイムAPI

リアルタイムAPIの導入—アプリケーションにスピーチ・トゥ・スピーチの体験を組み込むことができます。ChatGPTの高度な音声機能と同様ですが、あなた自身のアプリケーション用です。有料プランの開発者向けにベータ版として展開中です。

コンソールはGithubにまとまっており、自身で組み上げる必要あり

👉 https://github.com/openai/openai-realtime-console

↑完成後の操作イメージ画面

📑 ドキュメント

https://openai.com/index/introducing-the-realtime-api/

ドキュメントの要約

リアルタイムAPIの登場:アプリに高速な音声体験を組み込む時代へ

2024年10月1日、OpenAIは新たにリアルタイムAPIを発表しました。これにより、開発者は低遅延で音声を用いた体験をアプリに簡単に組み込むことができるようになります。例えば、ChatGPTの高度な音声モードのように、自然な音声対話を実現することができ、リアルタイムAPIは6つのプリセット音声をサポートしています。

また、Chat Completions APIにも音声入出力機能が追加され、低遅延が不要な場合でも、テキストや音声を入力し、テキストや音声で応答を受け取ることが可能になります。これにより、複数のモデルを統合する必要がなく、シンプルに自然な会話体験を提供できるようになります。

仕組みの詳細

従来、音声アシスタントを構築する際は、音声認識モデル(例:Whisper)で音声を文字起こしし、テキストモデルで推論し、最終的にテキストから音声に変換する必要がありました。このプロセスでは、感情やアクセントが失われたり、遅延が発生することがありました。リアルタイムAPIでは、これをすべて1回のAPI呼び出しで処理でき、さらに音声入出力をストリーミングすることで、より自然な対話が可能になります。例えば、会話中の割り込みを自動で処理したり、音声アシスタントがユーザーのリクエストに応じて行動を取ることもできます。

すでに活用されているケース

現在、いくつかのパートナー企業がリアルタイムAPIを活用しており、いくつかの興味深い事例があります。

- Healthify:栄養とフィットネスをサポートするアプリで、AIコーチ「Ria」が自然な対話を通じてユーザーを指導し、必要に応じて人間の栄養士がサポートに入る仕組みを実現。

- Speak:言語学習アプリで、ロールプレイ機能を通じて、ユーザーが新しい言語で会話を練習できる体験を提供。

価格と利用開始

リアルタイムAPIは、テキストトークンとオーディオトークンを利用しており、価格は入力トークン100万個につき5ドル、出力トークン100万個につき20ドルです。これにより、音声入力は1分あたり約0.06ドル、音声出力は1分あたり0.24ドルとなります。今後数週間以内に、Chat Completions APIでも音声機能が利用可能になる予定です。

安全性とプライバシー

リアルタイムAPIは多層的な安全保護機能を備えており、APIの悪用リスクを軽減するために自動監視や人間によるレビューが行われます。さらに、ユーザーがAIと対話していることを明示することが求められています。これらのセーフティ機能は、すでにChatGPTの音声モードで実証済みです。

今後の展開

リアルタイムAPIは今後、ビジョンやビデオなどのモダリティの追加、レート制限の拡大、SDKの公式サポートなど、多くの新機能が追加される予定です。開発者はすでにこのAPIを利用して、教育、翻訳、カスタマーサービス、アクセシビリティなど、多岐にわたる分野で新たなオーディオ体験を創出することが可能です。

リアルタイムAPIの詳細については、Playgroundや公式ドキュメントを参照してください。

このAPIにより、音声を活用した対話型アプリケーションの開発が格段に容易になり、顧客サポートから言語学習まで、さまざまな分野での革新が期待されます。

Prompt Caching(プロンプトキャッシング)

Prompt Cachingが利用可能になりました。これにより、モデルが最近見た入力トークンを再利用できるようになり、50%割引でさらに多くのキャッシュされたコンテキストをモデルに追加することができます。しかも、レイテンシーに影響を与えることなく実現できます。

この機能により、長文の処理や繰り返しの多いタスクでのコスト効率が大幅に向上し、より効果的なAI活用が可能になります

ドキュメントの要約

APIにおけるプロンプトキャッシングの導入:コストとレイテンシを削減する新機能

2024年10月1日、OpenAIは新たにプロンプトキャッシング機能を導入しました。これにより、開発者は同じコンテキストを繰り返し使用するAPI呼び出しにおいて、コストを削減し、処理時間を短縮することが可能になります。この機能は、たとえばコードベースの編集や、長時間にわたる多ターンの会話などで同じ入力が繰り返し使われる場合に特に有効です。

プロンプトキャッシングは、最近使用した入力トークンを再利用することで、50%の割引と高速な処理時間を提供します。

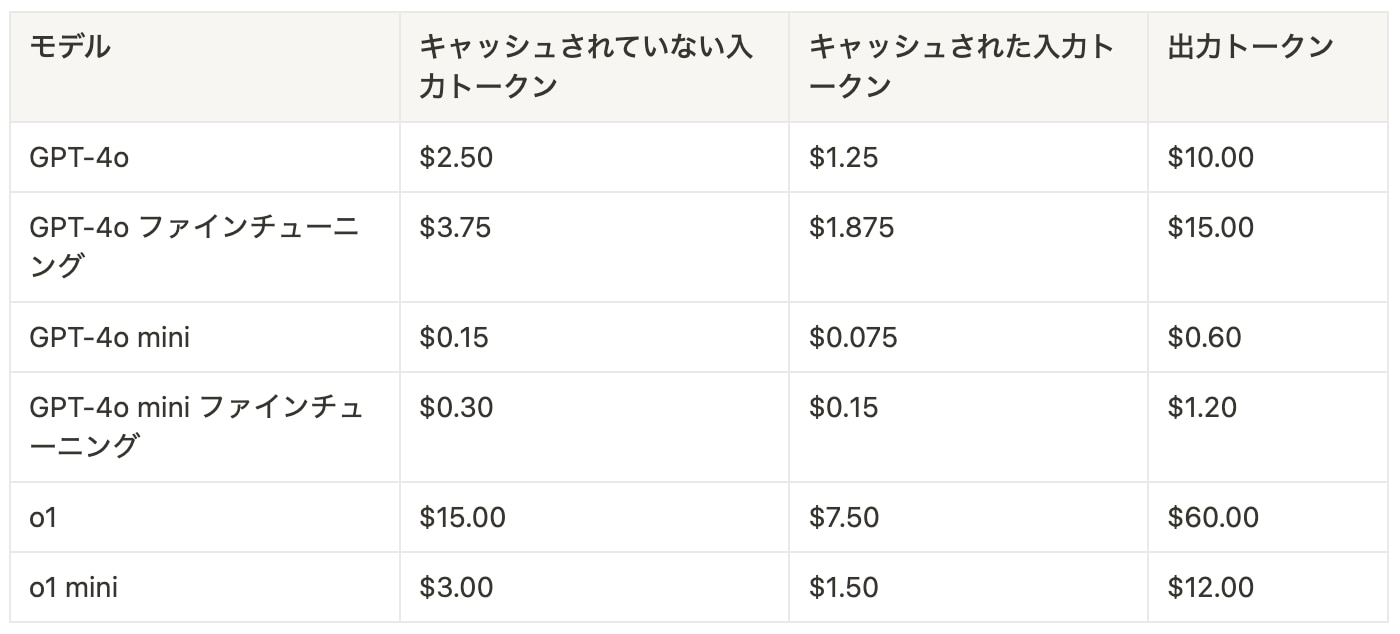

プロンプトキャッシングの利用可能性と価格設定

この機能は、最新バージョンのGPT-4o、GPT-4o mini、o1-previewおよびそれらの微調整バージョンで自動的に適用されます。キャッシュされたプロンプトは、キャッシュされていないプロンプトよりも割引された価格で提供されます。

以下に価格の概要を示します:

キャッシュ使用状況のモニタリング

プロンプトキャッシングは、1,024トークンを超えるプロンプトに対して自動的に適用され、APIは以前に計算されたプロンプトの最長部分をキャッシュします。トークンは128トークン単位で増加しますが、よく使われる共通のプロンプト部分を再利用する場合、自動的に割引が適用されます。

APIレスポンスの「usage」フィールドに、キャッシュされたトークンの情報が含まれ、キャッシュの活用状況が確認できます。

プロンプトキャッシュは、通常5~10分間の非アクティブ状態でクリアされ、1時間以内には完全に削除されます。また、キャッシュは組織間で共有されることはありません。

プロンプトキャッシングの活用

この機能は、コスト、パフォーマンス、レイテンシのバランスを取りながらアプリケーションをスケールさせるための重要なツールです。詳細はプロンプトキャッシングのドキュメントを参照してください。

この新機能により、開発者はリソースを効率的に活用し、より高速でコスト効率の高いAIアプリケーションを構築できるようになります。

introducing Model Distillation(モデル蒸留)

モデル蒸留(じょうりゅう?)の導入 - Evalsとストアド・コンプリーションを含む、大規模モデルの出力を使用して小規模で費用対効果の高いモデルを微調整するワークフローを導入します。

この新しい機能により、開発者は大規模な言語モデルの能力を活用しつつ、より効率的で運用コストの低いモデルを作成することが可能になります。モデル蒸留プロセスを通じて、小規模なモデルでも高性能な結果を得られるようになり、リソースの最適化とアプリケーションのパフォーマンス向上を同時に実現できます。

ドキュメントの要約

モデル蒸留の新機能をAPIに導入:コスト効率の高いモデルを簡単にチューニング

2024年10月1日、OpenAIはモデル蒸留(Model Distillation)の新機能を発表しました。これにより、開発者は大規模な最先端モデル(例:GPT-4oやo1-preview)の出力を活用して、よりコスト効率の高いモデル(例:GPT-4o mini)の性能を向上させることができます。モデル蒸留は、特定のタスクで高性能モデルに匹敵する性能を、はるかに低コストで実現できる手法です。

従来、モデル蒸留は複雑で多段階のプロセスを伴い、手動で複数のツールを連携させる必要がありましたが、新しいモデル蒸留スイートにより、このプロセスが一元化され、手軽に行えるようになりました。

モデル蒸留スイートの機能

新しいモデル蒸留スイートには、次の機能が含まれています:

- Stored Completions:モデルの入力と出力ペアを自動でキャプチャし、データセットを構築できます。これにより、実際のプロダクションデータを使用して簡単にデータセットを作成し、評価や微調整に活用可能です。

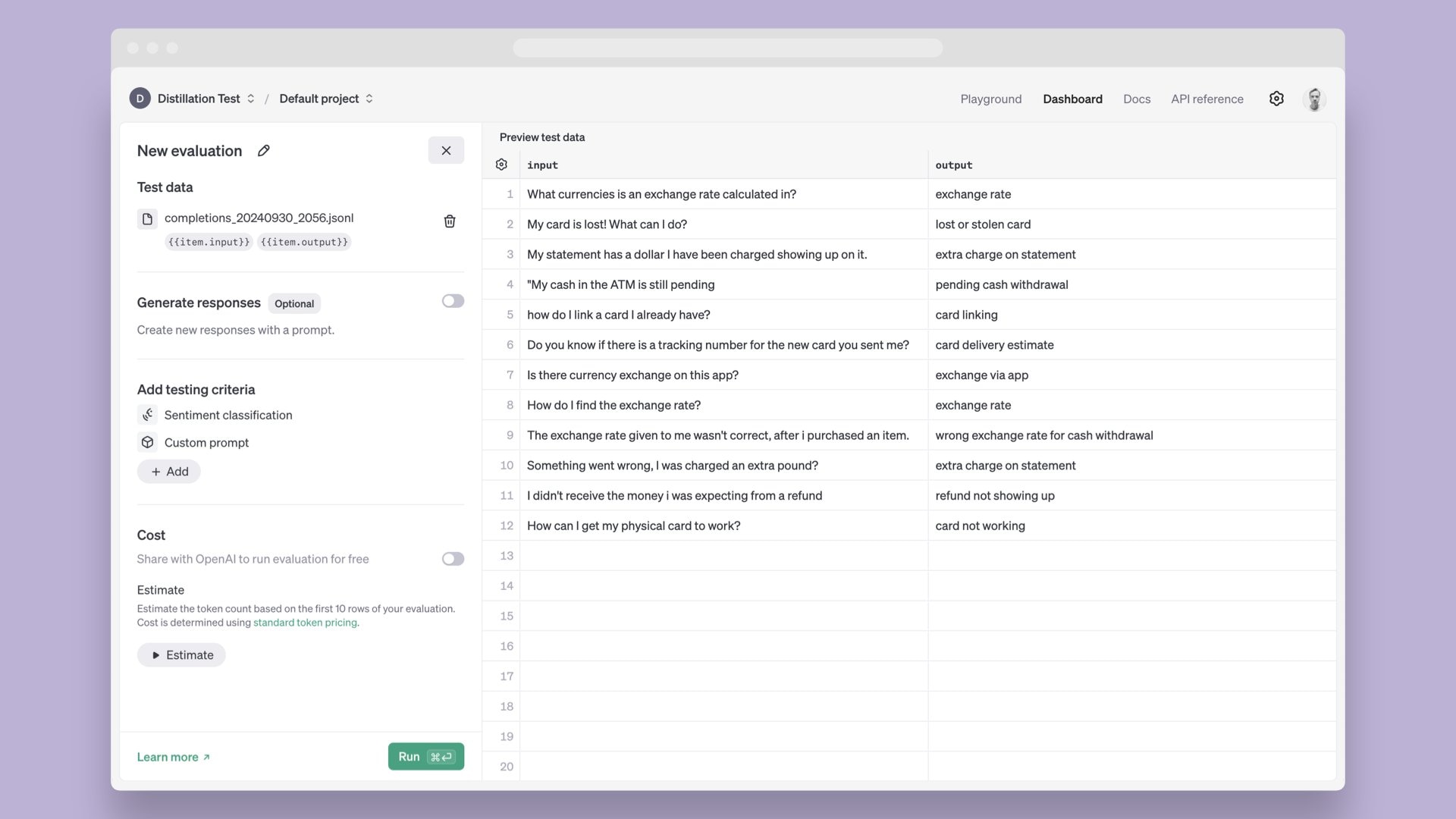

- Evals(ベータ版):モデルの性能を測定するための評価を簡単に作成し、実行できます。Stored Completionsのデータや、既存のデータセットをアップロードしてカスタム評価を行うことも可能です。

- 微調整(Fine-tuning):Stored CompletionsやEvalsを活用して、モデルの微調整と性能評価を一体化したワークフローが実現できます。

モデル蒸留の使い方

- 評価の作成

まず、GPT-4o miniのような小型モデルに蒸留するための評価を作成します。この評価は、蒸留後のモデルの性能を継続的にテストし、展開するかどうかを判断するために使用します。 - Stored Completionsでデータセットを作成

GPT-4oの出力を使用して、蒸留に必要な実例のデータセットを構築します。APIにstore:trueフラグを設定することで、入力と出力のペアが自動的に保存され、レイテンシに影響を与えることなくデータセットを作成できます。 - 微調整の実行

作成したデータセットを用いて、GPT-4o miniの微調整を行います。その後、Evalsを使用して、微調整されたモデルの性能が目標に達しているかを確認します。このプロセスは反復的に行われ、必要に応じてデータセットやトレーニングパラメータを調整して、モデルの性能を向上させます。

利用可能性と価格

モデル蒸留は本日より利用可能で、GPT-4oやo1-previewを含むすべてのモデルに適用できます。2024年10月31日まで、GPT-4o miniで1日あたり200万トークン、GPT-4oで100万トークンの無料トレーニングトークンが提供されます。それ以降のトレーニング費用は、通常の微調整価格に従います。

Stored Completionsは無料で利用でき、Evalsはベータ版として提供され、使用したトークンに基づいて標準モデル価格が適用されます。さらに、年内はEvalsをOpenAIと共有することで、1週間に最大7回まで無料で評価を実行することが可能です。

モデル蒸留は、性能、コスト、効率を最適化しながら、開発者がAIモデルを簡単に微調整できる強力なツールです。詳細はモデル蒸留のドキュメントをご覧ください。

この新機能により、開発者は大規模モデルの力を最大限に活用しつつ、コスト効率の高い小型モデルをプロダクション環境で運用できるようになります。

vision fine-tuning(ビジョンファインチューニング)

ビジョンファインチューニングのサポートを追加しました。テキストに加えて、画像を使ってGPT-4oをファインチューニングできるようになりました。10月31日まで、1日あたり100万トークンまで無料でトレーニングが可能です。

📑 ドキュメント

https://openai.com/index/introducing-vision-to-the-fine-tuning-api/

ドキュメントの要約

GPT-4oに画像とテキストのファインチューニング機能を導入:視覚能力を向上させる新しい時代へ

2024年10月1日、OpenAIはGPT-4oのファインチューニングにビジョン機能を導入し、画像とテキストを組み合わせてモデルをファインチューニングできるようにしました。これにより、開発者はGPT-4oの視覚理解能力を強化し、たとえばビジュアル検索機能の向上、自動運転車やスマートシティにおける物体検出の改善、医療画像解析の精度向上といった応用が可能になります。

これまで、テキストデータのみを使用してGPT-4oをカスタマイズし、特定のタスクに最適化する開発者が数多く存在しました。しかし、テキストだけでは性能向上が十分でないケースも多くありました。今回のビジョン機能の追加により、画像を使ったファインチューニングが可能になり、さらに強力なカスタマイズが実現します。

仕組み

ビジョンファインチューニングのプロセスは、テキストを使ったファインチューニングと似ています。開発者は、適切なフォーマットで画像データセットを準備し、それをプラットフォームにアップロードすることで、視覚タスクにおけるGPT-

4oの性能を強化できます。100枚の画像から始めて効果を実感でき、テキストと画像のデータ量が増えるほど性能が向上します。

実際の応用例

ビジョンファインチューニングはすでに多くの企業でテストされており、いくつかの実例を紹介します。

- Grabの道路上での画像検出と理解の改善

食品配達やライドシェアを手がけるGrabは、ドライバーから集めたストリートレベルの画像を地図データに変換し、東南アジア全域の運営を支える「GrabMaps」サービスを提供しています。GPT-4oを使用してわずか100例のデータでファインチューニングした結果、交通標識のローカライズ精度が13%向上し、車線のカウント精度も20%改善され、以前は手作業だったマッピング作業を自動化できるようになりました。 - Automatによるビジネスプロセス自動化の成功率向上

企業向けの自動化ソリューションを提供するAutomatは、デスクトップおよびWebエージェントを構築してドキュメント処理やUI操作を自動化しています。スクリーンショットを使ったビジョンファインチューニングにより、GPT-4oが自然言語の指示に基づいてUI要素を特定できるようにし、RPAエージェントの成功率が16.6%から61.67%に向上しました。さらに、未構造化の保険書類200枚を用いてファインチューニングを行った結果、情報抽出タスクでF1スコアが7%向上しました。 - Coframeによるデジタルコンテンツ作成の品質向上

Coframeは、企業がウェブサイトやUIのバリエーションを継続的に作成し、ビジネス指標を最適化するためのAIアシスタントを開発しています。GPT-4oに画像とコードを使ってファインチューニングを施すことで、ウェブサイトの一貫したビジュアルスタイルとレイアウトの生成能力が26%向上しました。

安全性とプライバシー

すべてのファインチューニングされたモデルに対して自動化された安全性評価を実施し、使用状況をモニタリングしています。ファインチューニングされたモデルは開発者の管理下にあり、ビジネスデータは完全に保護されています。明示的な許可がない限り、このサービスに使用されたデータでモデルのトレーニングは行われません。

利用可能性と価格

ビジョンファインチューニング機能は、今日からすべての有料開発者が利用可能です。2024年10月31日まで、GPT-4oを画像でファインチューニングする際に、1日あたり100万トークンが無料で提供されます。それ以降の価格は、1Mトークンあたり25ドルで、推論は1M入力トークンあたり3.75ドル、1M出力トークンあたり15ドルとなります。画像の入力はサイズに基づいてトークン化され、テキスト入力と同じ価格が適用されます。

始め方

ファインチューニングダッシュボードにアクセスし、「create」をクリックして、ベースモデルとして「gpt-4o-2024-08-06」を選択します。詳細は公式ドキュメントをご覧ください。

この新しいビジョンファインチューニング機能により、開発者はAIの視覚的な理解力を強化し、さまざまな分野でより正確で効率的なAIシステムを構築できるようになります。

Playground features(プロンプトジェネレーター)

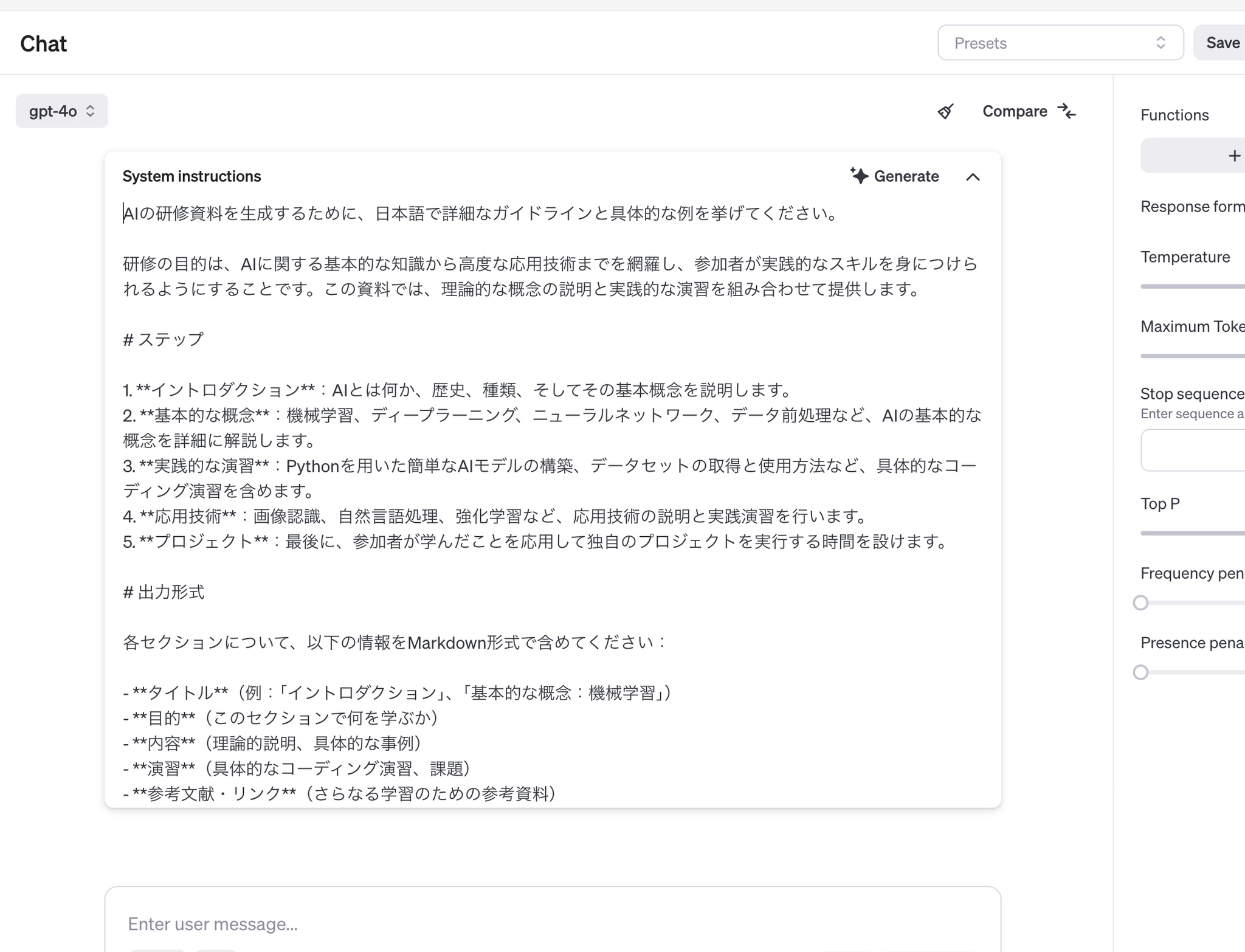

新しいPlayground機能—アイデアを素早くプロトタイプに変換します。モデルの使用目的を説明すると、Playgroundが自動的にプロンプトを生成し、関数や構造化された出力のための有効なスキーマを提供します。

この新機能により、開発者はより効率的に実験を行い、AIモデルの能力を最大限に引き出すことができます。具体的には以下のような利点があります:

- 迅速なプロトタイピング:アイデアを素早く形にし、実験的な実装を簡単に行えます。

- 自動プロンプト生成:使用目的に基づいて最適化されたプロンプトを自動生成し、より効果的なモデル利用を支援します。

- スキーマの自動生成:関数呼び出しや構造化された出力のための有効なスキーマを自動的に提供し、開発プロセスを簡素化します。

- 学習曲線の緩和:AIモデルの複雑な使用方法を理解しやすくし、新規ユーザーの参入障壁を下げます。

この機能により、開発者はより創造的にAIモデルを活用し、革新的なアプリケーションやサービスを迅速に開発できるようになります。

↑「生成AIの研修をしたい」からシステムプロンプトが自動生成!

o1 API 制限緩和

OpenAI o1 API—開発者のアクセスをusage tier 3まで拡大し、レート制限を引き上げています(GPT-4oと同じ制限まで)。これにより、アプリケーションを本番環境で使用できるようになります。

Tier 5 o1-preview: 1分あたり10,000リクエスト o1-mini: 1分あたり30,000リクエスト

Tier 4 o1-previewとo1-mini: 1分あたり10,000リクエスト

Tier 3 o1-previewとo1-mini: 1分あたり5,000リクエスト

この制限緩和により、より多くの開発者がo1 APIを活用し、高性能なAIアプリケーションを構築できるようになります。特にTier 3の開発者にとっては、本番環境での使用が現実的になり、アプリケーションのスケーラビリティが向上します。

その他

見逃せない関連情報が続々届いてました!

An AI companion for everyone

https://blogs.microsoft.com/blog/2024/10/01/an-ai-companion-for-everyone/

Copilotの音声も[RealTimeAPI]を使ってそうです。

流暢に喋るVerUPがされるようです。

誰もが利用できるAIコンパニオン ~マイクロソフトの新たな挑戦~

2024年10月1日 | マイクロソフト コーポレートブログ

私たちは今、技術のパラダイムシフトを迎えています。数年の間に、コンピュータは私たちの言語を理解し、視覚や聴覚を通じて世界を捉える能力を身につけました。しかし、技術そのものが重要なのではなく、それが人々にどのように感じられ、社会にどんな影響を与えるかが本質です。技術は人間の幸福を増幅し、数十億人に持続可能な利益をもたらす最も効果的な手段の一つです。

AIは人類のために

マイクロソフトAIでは、「誰もが利用できるAIコンパニオン」を創造しています。私たちの目指すのは、感情に寄り添い、日常生活をサポートする穏やかで役立つ技術の時代です。Copilotはあなたのそばに立ち、プライバシーとセキュリティを守りながら、必要な情報を提供し、日々のストレスを軽減します。時間とともにあなたの習慣やニーズに適応し、創造性や人間関係の構築を支援します。

Copilotの新機能と展開

- Copilot Voice

自然な対話を可能にする音声機能。4つの声オプションから選べ、外出先でもブレインストーミングや質問、リラックス時の会話が可能です。 - Copilot Daily

朝のニュースや天気をあなたの好みの声でお届け。情報過多を防ぎ、シンプルで分かりやすい内容を提供します。 - Personalized Discover

Copilotの機能ガイドや会話のきっかけを提供し、マイクロソフトサービスとの連携で個々にカスタマイズされた体験を提供します。 - Microsoft Edgeとの統合

ブラウザ内で@copilotと入力するだけで、質問への回答やページ内容の要約、翻訳などが簡単に利用可能です。 - Copilot Labs

実験的な機能を試す場として、Copilot VisionやThink Deeperなどの新機能を提供。ユーザーからのフィードバックを基に安全性を高めつつ開発を進めています。

安全性とプライバシーの確保

Copilot Visionはオプトイン制で、セッション終了後はデータが完全に削除されます。また、限定されたウェブサイトのみでの利用とし、敏感なコンテンツには対応していません。ユーザーのプライバシーと安全性を最優先に考えた設計です。

今後の展望

CopilotはiOS、Android、Windows、そしてWhatsAppでも順次展開予定。BingやMSNなど他のマイクロソフトサービスとも連携し、よりパーソナライズされた検索体験を提供します。これは単なるツールの進化ではなく、私たちの生活を豊かにし、可能性を広げる新たな技術の幕開けです。

最後に

私たちの使命は、AIが人々の生活を豊かにし、人間らしさを損なわないようにすることです。Copilotはその第一歩であり、皆さんと共に歩む長い旅の始まりです。ご意見やフィードバックをお寄せいただき、一緒に未来を創りましょう。

マスタフ・スレイマン

マイクロソフトAI 最高経営責任者

今回は以上です。